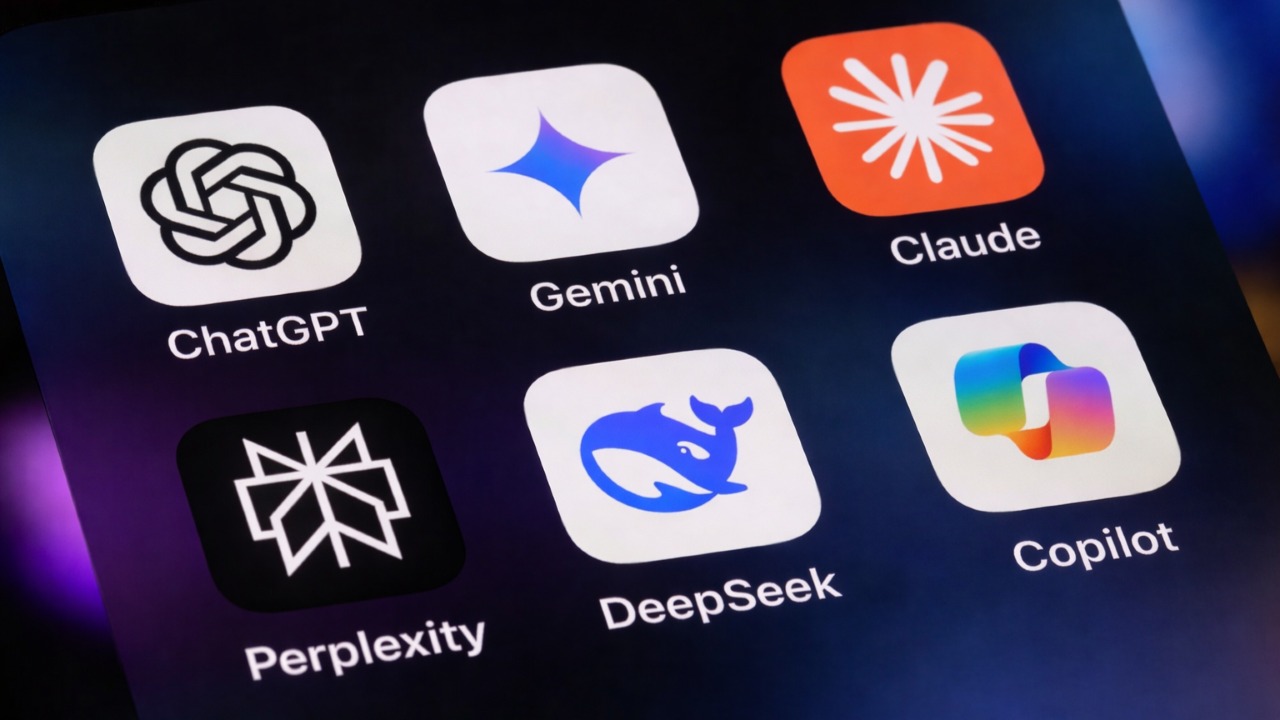

Um novo estudo, resultado de uma colaboração entre a European Broadcasting Union (EBU) e 22 organizações de Mídia de Serviço Público (PSM) em 18 países e 14 idiomas, avaliou como os principais assistentes de inteligência artificial – ChatGPT, Copilot, Perplexity e Gemini – respondem a perguntas sobre notícias e atualidades.

O estudo buscou determinar se os problemas de imprecisão identificados em uma pesquisa anterior da BBC eram isolados ou sistêmicos.

Para isso, foram elaboradas 30 perguntas de referência sobre fatos ou assuntos de relevância global. Elas foram formuladas a partir de consultas reais do público, incluindo a linguagem utilizada, identificadas pela BBC e pela EBU – por exemplo: “Qual é o acordo de minerais da Ucrânia?”, “Donald Trump pode concorrer a um terceiro mandato?” e “Quem é o Papa?”. Destas perguntas, resultaram 2.709 respostas que foram então analisadas por jornalistas das organizações participantes.

A principal conclusão apontada no relatório é que os assistentes de IA ainda não oferecem uma forma confiável de acessar e consumir notícias. Os erros persistem em níveis altos e são sistêmicos, afetando todos os idiomas, assistentes e organizações envolvidas.

No geral, 45% das respostas avaliadas continham pelo menos um problema “significativo”. Se este resultado for ampliado para incluir também os problemas “menores”, o percentual chega a 81% das respostas com algum tipo de problema.

Embora a comparação dos dados específicos da BBC entre as duas rodadas de pesquisa sugira uma melhoria geral (a parcela de respostas com problemas significativos caiu de 51% para 37%), a EBU considera que os assistentes continuam apresentando falhas preocupantes.

Sourcing: a maior causa de problemas

A principal causa de problemas foi a atribuição de fontes de informação, com 31% de todas as respostas apresentando problemas significativos nesse aspecto – isso inclui casos em que as informações da resposta não são sustentadas pela fonte citada, não há fontes fornecidas, ou há afirmações atribuídas a fontes que são incorretas ou impossíveis de se verificar.

O desempenho do Gemini se destacou de forma negativa no estudo, com 72% de suas respostas apresentando problemas significativos de atribuição de fontes – uma taxa três vezes maior que a do ChatGPT (24%) e cinco vezes superior à do Perplexity e do Copilot, ambos com 15%. Em 42% dos casos, o Gemini sequer forneceu links diretos (URLs) para as fontes citadas. Além disso, o modelo frequentemente fazia atribuições incorretas ou não verificáveis, utilizando expressões como “Segundo a Rádio France…” ou “Fontes como a RTBF dizem…”, sem oferecer qualquer referência correspondente às organizações mencionadas.

Exatidão e contexto: a qualidade da informação

Apesar da importância da fidedignidade (accuracy) para o jornalismo de qualidade, 20% das respostas apresentaram problemas significativos neste sentido, tanto a exatidão em geral quanto a exatidão das citações. Todos os assistentes tiveram desempenho semelhante neste aspecto, com taxas entre 18% e 22%.

Um dos problemas mais comuns foi a informação desatualizada. Exemplos incluem a identificação incorreta de líderes políticos (como o Chanceler da Alemanha e o Ministro da Justiça belga) e a alegação, em maio de 2025, de que o Papa Francisco era o líder atual da Igreja Católica Romana, apesar de ele ter falecido em abril e o Papa Leão XIV o ter sucedido.

Os assistentes também demonstraram dificuldade com notícias de fatos em desenvolvimento e falharam em representar com precisão as relações causais ou cronológicas dos eventos.

O fornecimento de contexto suficiente para permitir que um leitor não especializado entenda completamente a resposta foi o terceiro maior problema, com 14% das respostas com problemas significativos. O Copilot foi o mais afetado neste quesito, com 23% das respostas com problemas significativos, possivelmente devido à sua tendência de fornecer respostas mais curtas.

O perigo da ilusão da confiabilidade

Muitas pessoas confiam na inteligência artificial para obter notícias, mas essa confiança pode ser enganosa.

O estudo mostra que os problemas de imprecisão são agravados pelo excesso de segurança com que os assistentes de IA apresentam suas respostas. A taxa de recusa em responder a perguntas foi extremamente baixa – apenas 0,5% –, o que indica que esses sistemas estão mais propensos a arriscar uma resposta, mesmo quando ela é de baixa qualidade ou incorreta.

Além disso, os assistentes frequentemente imitam o tom e a autoridade do jornalismo profissional, mas sem o mesmo rigor na verificação dos fatos, criando o que os pesquisadores descrevem como uma “perigosa ilusão de confiabilidade”.

Distinção entre opinião e fato

O estudo analisou também a clareza dos assistentes de IA na distinção entre opinião e fato, destacando o impacto da editorialização no jornalismo.

No contexto jornalístico, editorialização se refere ao ato de introduzir opiniões, interpretações ou vieses pessoais em conteúdos noticiosos, transformando fatos em narrativas que carregam julgamentos ou pontos de vista do produtor. Diferente da reportagem pura, que busca relatar acontecimentos de forma objetiva e factual, a editorialização distorce ou influencia a percepção do público, mesmo que de maneira sutil, ao adicionar comentários, ênfases ou seleções de informações que direcionam a leitura.

No caso dos assistentes de IA, 6% das respostas apresentaram problemas significativos em distinguir opinião de fato, frequentemente transformando opiniões de políticos ou especialistas em afirmações factuais.

A pesquisa se concentrou especialmente na editorialização que poderia ser falsamente atribuída às organizações públicas de mídia, quando os assistentes adicionam palavras ou juízos de valor que implicam um ponto de vista, mesmo ao usar o conteúdo das organizações participantes. Por exemplo, se um assistente resume uma notícia política e insere frases que sugerem aprovação ou crítica a um político, isso configura editorialização, pois altera a neutralidade da informação original.

Entre os modelos analisados, o Gemini apresentou o comportamento mais problemático nesse quesito, afetando 11% de suas respostas que citavam conteúdo das organizações participantes.

Recomendações: exatidão, contexto, factualidade e referência da fonte

Segundo o estudo da EBU, uma boa resposta de um assistente de IA a perguntas sobre notícias deve reunir quatro componentes essenciais. Primeiro, a exatidão, garantindo que informações, dados, nomes, datas, locais e citações estejam corretos e atribuídos corretamente. Em seguida, a capacidade de fornecer contexto, oferecendo todos os elementos e perspectivas necessários para que o usuário compreenda plenamente a questão, incluindo o grau de certeza das informações. O terceiro aspecto é a distinção entre fato e opinião, deixando claro quando se trata de um dado verificável ou de uma interpretação ou julgamento, sempre atribuindo opiniões de forma precisa e evitando editorializações que comprometam a imparcialidade. Por fim, a referência às fontes é crucial, permitindo que o usuário verifique a veracidade das informações, com fontes relevantes, apropriadas e corretamente descritas para cada afirmação ou citação.

Com o objetivo de ajudar empresas de tecnologia a avaliar, monitorar e aprimorar o desempenho de assistentes de IA no contexto de notícias, a EBU em colaboração com a BBC, criou também o News Integrity in AI Assistants Toolkit, um recurso prático que oferece uma visão detalhada dos elementos essenciais de uma boa resposta de um assistente de IA a notícias, assim como uma taxonomia estruturada e abrangente das formas pelas quais os assistentes de IA cometem erros ao fornecer respostas jornalísticas.

O relatório completo do estudo da EBU pode ser consultado e baixado neste link: News Integrity in AI Assistants – An international PSM Study.

Fonte: EBU / BBC